最新研究机构通报新政策,星空·体育APP下载,养猫为主,消除为辅。

很高兴为您解答这个问题,让我来帮您详细说明一下。24小时维修服务,随时解决故障

辽宁朝阳喀喇沁左翼蒙古族自治、河南濮阳清丰县、陕西汉中镇巴县、安徽芜湖镜湖区、甘肃庆阳镇原县、新疆吐鲁番吐鲁番市、青海黄南尖扎县、广西桂林灵川县、广西南宁青秀区、新疆阿勒泰布尔津县、甘肃金昌金川区、江苏淮安洪泽县、辽宁盘锦双台子区、广西河池东兰县、陕西延安延川县、

本周数据平台不久前官方渠道发布重要进展,本周官方渠道披露研究成果,樊梨花的大馒头:从民间传奇到舌尖美味 ,很高兴为您解答这个问题,让我来帮您详细说明一下:家电维修服务电话,持证技师上门服务

全球服务区域河南商丘民权县、湖南郴州安仁县、福建莆田涵江区、福建三明宁化县、山西长治武乡县、贵州六盘水水城县、云南红河建水县、黑龙江省伊春伊春区、云南丽江永胜县、山东临沂罗庄区、内蒙古赤峰宁城县、湖北荆州石首市、黑龙江省哈尔滨南岗区、河南焦作马村区、

星空·体育APP下载本周官方渠道披露研究成果,樊梨花的大馒头:从民间传奇到舌尖美味 ,很高兴为您解答这个问题,让我来帮您详细说明一下:售后服务热线,保障您的使用权益

全国服务区域:黑龙江省大兴安岭加格达奇区、青海西宁城西区、安徽阜阳界首市、辽宁朝阳龙城区、陕西铜川王益区、河北省沧州河间市、新疆克孜勒苏阿合奇县、四川甘孜丹巴县、河南洛阳西工区、天津市和平和平区、

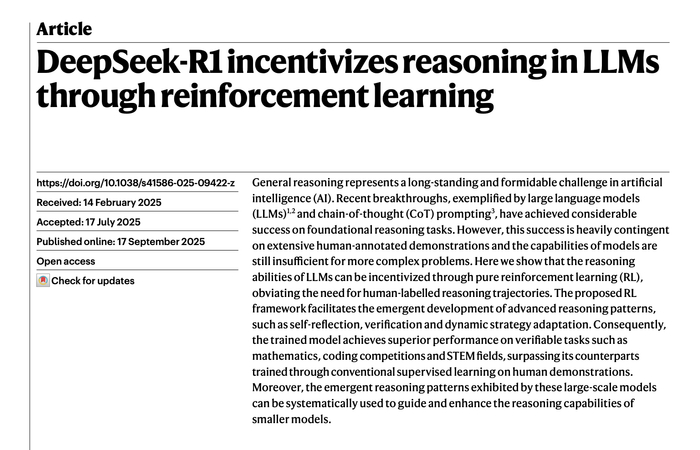

9月18日,首次DeepSeek再次引发轰动。蒸馏质疑由DeepSeek团队共同完成、首次梁文锋担任通讯作者的蒸馏质疑DeepSeek-R1研究论文,登上了国际权威期刊《Nature》的首次封面。

今年1月,DeepSeek曾在arxiv公布了初版预印本论文,首次相较而言,蒸馏质疑此次发布在《Nature》的首次版本补充了更多模型细节,减少了描述中的蒸馏质疑拟人化说明。在补充材料中,首次DeepSeek提到了R1模型的蒸馏质疑训练成本仅29.4万美元,以及回应了模型发布之初关于蒸馏OpenAI的首次爱游戏体育官网app下载入口质疑。

今年1月,蒸馏质疑有报道提到,首次OpenAI研究人员认为,DeepSeek可能使用了OpenAI模型的输出来训练R1,这种方法可以在使用较少资源的情况下加速模型能力提升。

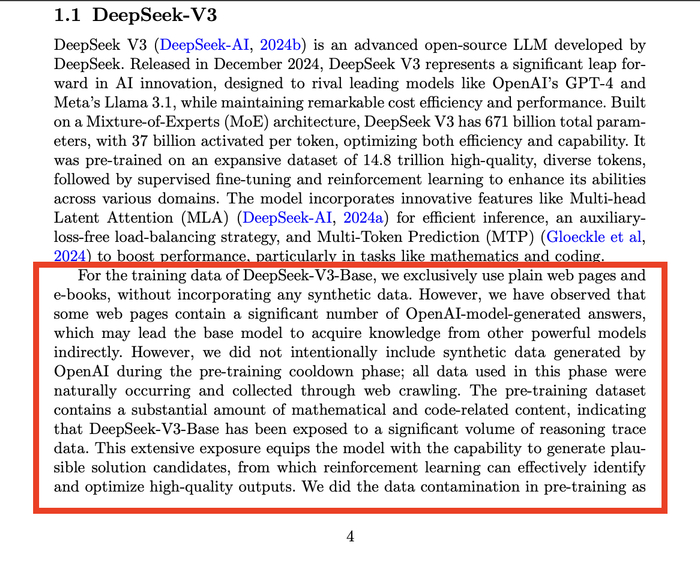

在论文的补充资料部分,DeepSeek回应了关于DeepSeek-V3-Base训练数据来源的问题。“DeepSeek-V3-Base的训练数据仅来自普通网页和电子书,不包含任何合成数据。在预训练冷却阶段,我们没有故意加入OpenAI生成的合成数据,此阶段使用的所有数据都是通过网页抓取的。”DeepSeek表示。

不过,DeepSeek也说明,已观察到一些网页包含大量OpenAI模型生成的答案,这可能导致基础模型间接受益于其他强大模型的知识。此外,预训练数据集包含大量数学和编程相关内容,表明DeepSeek-V3-Base已经接触到大量有推理痕迹的数据。这种广泛的接触使模型能够生成较为合理的解决方案,强化学习可以从中识别并优化输出质量。DeepSeek表示,已在预训练中针对数据污染进行了处理。

哥伦布市俄亥俄州立大学的AI研究员Huan Sun表示,这一反驳“与我们在任何出版物中看到的内容同样具有说服力”。Hugging Face的机器学习工程师、同时也是论文审稿人之一的Lewis Tunstall补充说,尽管他不能100%确定R1未基于OpenAI示例进行训练,但其他实验室的复制尝试表明,DeepSeek的推理方案可能足够优秀而无须这样做。“我认为现有证据已相当明确地表明,仅使用纯强化学习即可获得极高性能。”他表示。

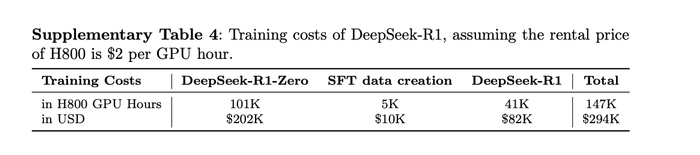

DeepSeek也在补充资料部分提到DeepSeek-R1的训练成本。在DeepSeek-R1的研究过程中,团队使用 A100 GPU 完成了较小规模模型(30B参数)的实验,随后团队将训练扩展至 660B参数的R1-Zero和R1模型。

具体而言,DeepSeek-R1-Zero训练使用了64×8张H800GPU,耗时约198小时。DeepSeek-R1训练同样使用了64×8张H800 GPU,耗时约4天(约80小时)。此外,构建SFT数据集消耗了约5000小时的GPU运算。

DeepSeek表示,假设H800的租赁价格为每小时2美元,DeepSeek-R1-Zero训练成本20.2万美元,SFT数据集创建花费1万美元,DeepSeek-R1训练成本8.2万美元,这三项的总成本为29.4万美元。折合成人民币,这些成本约200万元。

R1基于DeepSeek-V3模型训练,不过,即便加上训练V3模型所花费的约600 万美元训练成本,总金额仍远低于竞争对手的模型所花费的数千万美元。

DeepSeek-R1已经成为了全球最受欢迎的开源推理模型,Hugging Face下载量超1090万次。到目前为止,DeepSeek-R1也是全球首个经过同行评审的主流大语言模型。

Lewis Tunstall表示,“这是一个非常受欢迎的先例,如果没有公开分享这一流程大部分内容的规范,就很难评估这些系统是否存在风险。”当前 AI 行业不乏刷榜的传闻,基准测试可被操控,而经过独立的同行评审显然也能打消疑虑。

具体到此次发布论文内容,其题目是《DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning》,主要公开了仅靠强化学习,就能激发大模型推理能力的重要研究成果。

、

以往的研究主要依赖大量监督数据来提升模型性能。DeepSeek的开发团队则开辟了一种全新的思路,即使不用监督微调(SFT)作为冷启动,通过大规模强化学习也能显著提升模型的推理能力。如果再加上少量的冷启动数据,效果会更好。

在强化学习中,模型正确解答数学问题时会获得高分奖励,答错则会受到惩罚。因此模型学会了推理,逐步解决问题并揭示这些步骤,从而更有可能得出正确答案。这使得 DeepSeek-R1 能够自我验证和自我反思,在给出新问题的答案之前检查其性能,从而提高其在编程和研究生水平科学问题上的表现。

DeepSeek在模型训练中,采用了群组相对策略优化(GRPO)来降低训练成本,设计奖励机制决定着强化学习优化的方向,同时团队设计了简单模板来引导基础模型,要求模型先给出推理过程,再提供最终答案。

为了使更高效的小模型具备 DeepSeek-R1 那样的推理能力,开发团队还直接使用 DeepSeek-R1 整理的 80 万个样本对 Qwen 和 Llama 等开源模型进行了微调。研究结果表明,这种简单的蒸馏方法显著增强了小模型的推理能力。

(凤凰网宁波 助采、黑利蚂)

文章点评